Sommaire

IBM Cloud : un environnement optimisé pour l’IA

IBM a récemment annoncé un développement majeur pour les entreprises souhaitant progresser dans la mise en œuvre de l’intelligence artificielle. Désormais, les utilisateurs d’IBM Cloud pourront accéder aux puissantes instances GPU Nvidia H100 Tensor Core, offrant ainsi une opportunité unique de former et d’optimiser des grands modèles de langage (LLM) dans des environnements adaptés tels que le cloud privé virtuel et Red Hat OpenShift gérés.

Avec ces nouvelles capacités, IBM se positionne comme un acteur clé pour accompagner les entreprises dans leur transformation numérique. Comme le souligne Rohit Badlaney, directeur général d’IBM Cloud Product and Industry Platforms, le GPU Nvidia H100 permet d’obtenir des performances d’inférence pouvant atteindre 30 fois plus que l’ancien modèle A100 Tensor Core. Cela signifie une augmentation considérable de la vitesse de traitement pour les applications d’IA à grande échelle.

Flexibilité et évolutivité pour les entreprises

Grâce à cet accès élargi, les entreprises peuvent commencer par former des modèles à petite échelle, tout en ayant la possibilité de déployer des applications telles que des chatbots et des outils de prévision. Les GPU Nvidia L40S et L4 Tensor Core viennent compléter cette offre pour les besoins moins exigeants.

À mesure que les entreprises se développent et que les exigences en matière d’IA augmentent, elles pourront ajuster leurs dépenses et s’orienter vers les H100 pour gérer des cas d’utilisation plus complexes. Cela démontre l’engagement d’IBM à offrir une solution adaptée et évolutive pour tous les types d’applications AI.

Une connexion efficace pour des performances optimisées

IBM Cloud n’oublie pas l’importance des réseaux puissants pour supporter cette montée en puissance. En effet, l’entreprise a mis en place un réseau entièrement basé sur Ethernet pour gérer les charges de travail accrues. Grâce à la construction des hubs de traitement avancés à Washington et à Francfort, les clients peuvent bénéficier d’une communication GPU-GPU avec une configuration RoCE/RDMA capable d’atteindre 3,2 Tbps.

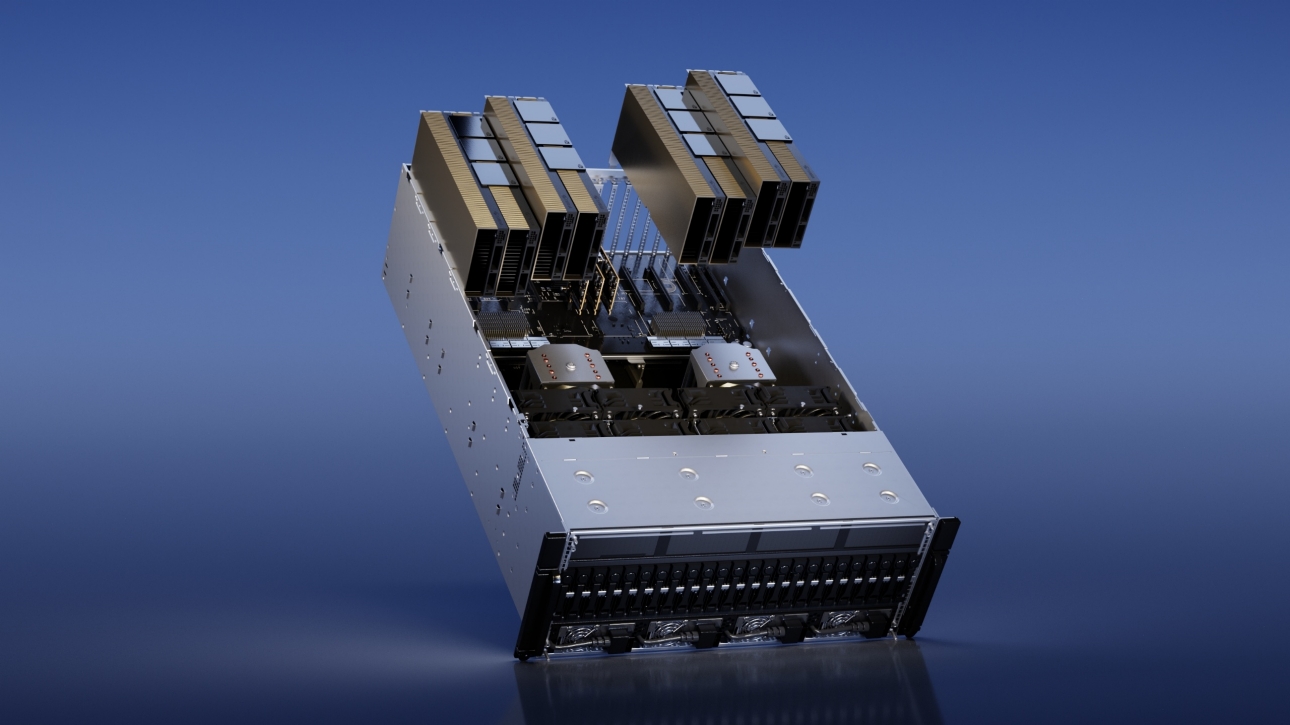

Pour une utilisation individuelle, les GPU H100 sont interconnectés avec NVLink de Nvidia, garantissant ainsi une communication rapide et efficace entre les unités. L’ensemble de ces technologies constitue une solution clé en main via la configuration Nvidia DGX, intégrant à la fois les A100 et H100 Tensor Core.

Sécurité : un enjeu majeur

Dans cet univers numérique en constante évolution, la sécurité des données est primordiale. Selon Rohit Badlaney, les services d’IBM Cloud intègrent divers protocoles de sécurité multi-niveaux pour protéger les processus d’IA et prévenir les fuites de données. Ces contrôles sont essentiels pour garantir la protection des charges de travail d’IA contre toute menace extérieure.

L’architecture de sécurité d’IBM Cloud propose également des services automatisés pour faciliter le déploiement des applications, réduisant ainsi le temps nécessaire à la configuration manuelle et minimisant les erreurs.

Watsonx et les services d’IA : une boîte à outils complète

Les clients d’IBM ont également accès à une suite d’outils avancés. Watsonx, le studio d’IA d’IBM, offre des fonctionnalités significatives pour le développement intensif de l’intelligence artificielle. Associé à un data lakehouse et à des solutions de gouvernance, ce panel d’outils est conçu pour maximiser les opportunités offertes par l’IA.

IBM et Nvidia : un partenariat renforcé

L’introduction des GPU H100 n’est qu’un des nombreux développements issus de la collaboration entre IBM Cloud et Nvidia. En début d’année, Big Blue a eu l’opportunité d’accéder en avant-première aux microservices d’IA générative de Nvidia. Ces ressources permettent aux clients de créer et déployer des applications personnalisées, optimisées pour les accélérateurs.

De plus, IBM intègre les puces Nvidia L40S et L4 Tensor Core, tout en offrant un support à Red Hat Enterprise Linux AI et OpenShift AI, consolidant ainsi son offre globale pour les entreprises désireuses de bâtir et exécuter des solutions d’IA robustes.

Conclusion

IBM Cloud se positionne résolument comme un pilier de l’intelligence artificielle avec l’établissement d’un accès facilité aux technologies avancées de Nvidia. Cette initiative offre des opportunités sans précédent pour les entreprises souhaitant évoluer dans le domaine de l’IA. De la formation de modèles à la mise en place d’applications performantes, IBM est prêt à accompagner chaque étape de ce voyage digital.