Sommaire

Dans une collaboration étroite, Mistral AI et Nvidia ont annoncé la sortie de Mistral NeMo 12B, un modèle de langage de grande taille conçu pour s’exécuter sur les GPU de Nvidia. Doté de 12 milliards de paramètres, ce modèle a été entraîné sur l’architecture de référence Nvidia DGX Cloud.

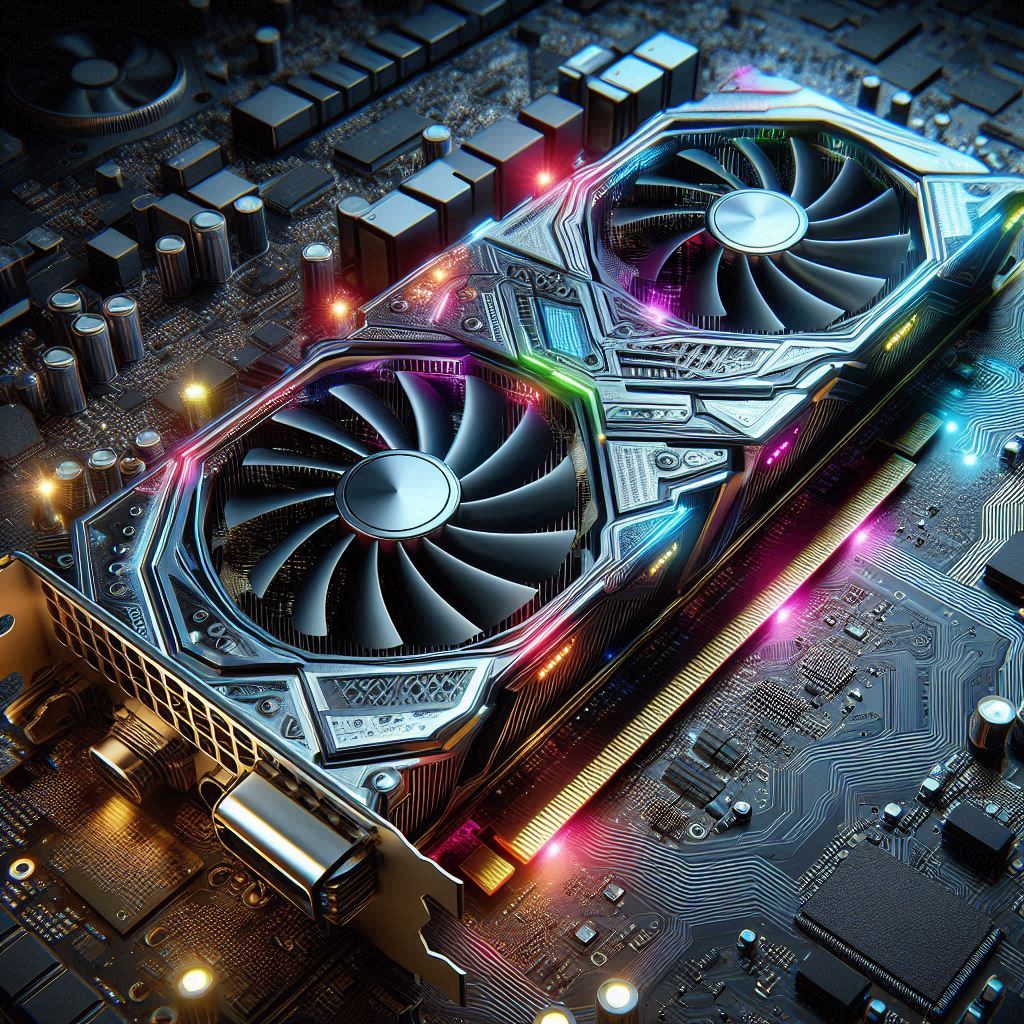

Un modèle taillé pour les GPU Nvidia

Mistral NeMo 12B a été conçu pour fonctionner sur le système d’inférence conteneurisé Nvidia NIM (NeMo Inference Microservices), avec une image optimisée pour le framework TensorRT de Nvidia. Le modèle peut également être déployé dans le cloud ou sur site avec les frameworks Mistral inference et transformers.

Des optimisations pour une meilleure performance

Le modèle a été optimisé pour fonctionner sur les GPU Nvidia L40S, RTX 4500 Ada et RTX 4090. Mistral AI a également optimisé le modèle pour la quantisation en FP8, ce qui permet de réduire l’espace occupé par le modèle en mémoire vive vidéo sans perte de performance. Mistral NeMo 12B a été entraîné pour répondre en anglais, français, allemand, espagnol, italien, portugais, chinois, japonais, coréen, arabe, hindi et propose également une optimisation pour les échanges multitours en anglais.

Des performances remarquables

Mistral NeMo 12B présente des performances supérieures à celles des modèles Llama 3-8B sur les benchmarks HellaSwag, ARC C et MMLU. Il dépasse également les modèles Gemma 2-9B et Llama 3-8B sur les évaluations HellaSwag, Winogrande, Natural IQ, TriviaQA, OpenBookQA, CommonSenseQA et Thruthful QA. Grâce à sa grande fenêtre de contexte, Mistral NeMo 12B peut traiter jusqu’à 128 000 tokens en entrée.

Tekken, un tokenizer plus efficace

Mistral AI introduit également un nouveau tokenizer, Tekken, qui offre une compression plus efficace que SentencePiece pour plusieurs langues, notamment le chinois, l’italien, le français, l’allemand, l’espagnol et le russe. Ce nouveau tokenizer offre également une meilleure compression pour le coréen et l’arabe.

Mistral NeMo 12B est dès à présent disponible sur la plateforme HuggingFace, ainsi que sur le catalogue d’API payantes de Mistral AI.